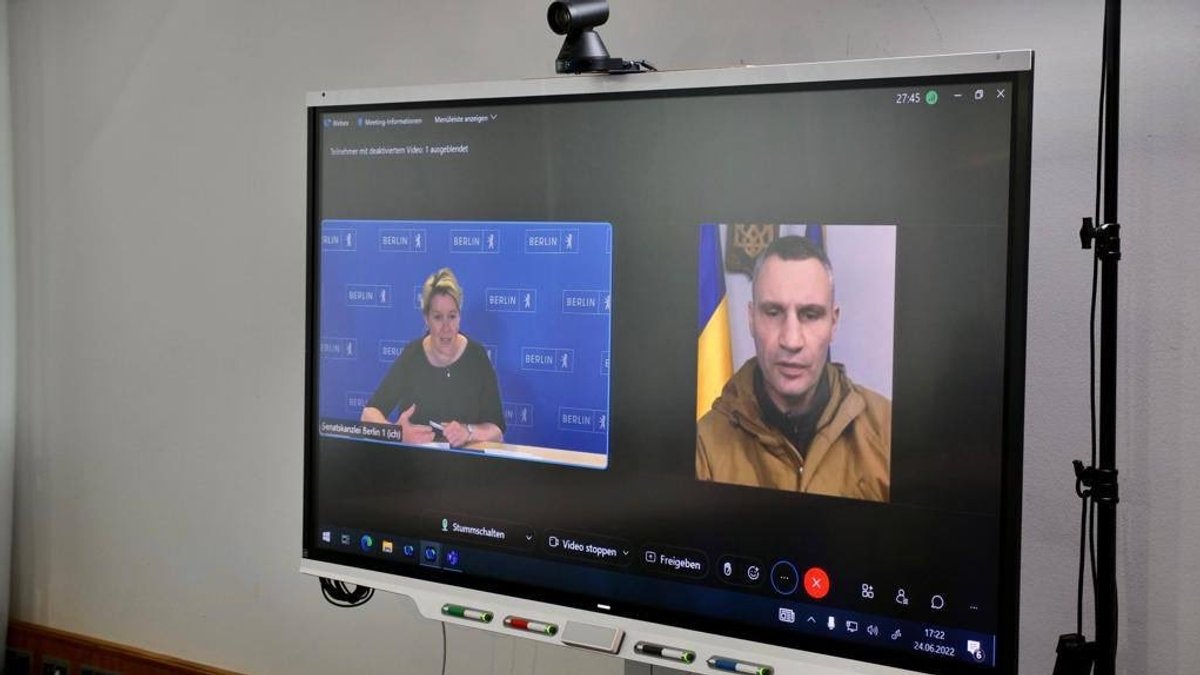

Ende Juni videotelefonierte die regierende Bürgermeisterin von Berlin Franziska Giffey etwa eine halbe Stunde mit jemandem, der zwar aussah wie Kiews Bürgermeister Vitali Klitschko, aber nicht Kiews Bürgermeister Vitali Klitschko war. Schnell hieß es, dass an diesem peinlichen Missverständnis ein Deepfake Schuld gewesen sei, eine perfide Videomanipulation mit Hilfe von künstlicher Intelligenz. Viele Medien übernahmen unkritisch diese Behauptung, obwohl Experten da schon längst skeptisch waren.

Photoshop für bewegte Bilder

Denn es stimmt zwar, dass es mit Hilfe der Deepfake-Technologie sehr einfach geworden ist, bewegte Bilder zu manipulieren. So wie mit Hilfe von Photoshop seit gut zwei Jahrzehnten auch Laien Bilder verändern können, hilft bei Deepfakes die künstliche Intelligenz dabei, beispielsweise Gesichter in einen Film hineinzumontieren.

Dazu braucht es eigentlich nur genügend Bildmaterial, ein kleines Programm, das man frei herunterladen kann, ein bisschen Know-how und viel Rechenpower. Nur: einen Deepfake zu machen, ist einfach, aber einen guten Deepfake zu machen, ist schwer. Meistens wirken die Augen zu starr oder es kommt zu merkwürdigen Schlieren im Bild.

Deepfakes sind ein Problem – aber auf andere Art, als man denkt

Fast unmöglich ist es, per Deepfake-Technologie ein Live-Video zu manipulieren, wie bei Giffeys Videokonferenz mit dem vermeintlichen Klitschko. Man hätte also wissen können, dass der Fake-Videocall mit dem Bürgermeister von Kiew nichts mit Deepfakes zu tun hat. Wenig später entpuppte sich der vermeintliche Deepfake dann auch als schnöder "Shallowfake", als herkömmliche Fälschung, die ganz ohne künstliche Intelligenz auskommt. Vermutlich wurde für den falschen Klitschko einfach bestehendes Video-Material neu arrangiert.

Dass die Deepfake-Erklärung trotzdem gerne geglaubt wurde, hat damit zu tun, dass seit Jahren die Gefahr von Deepfakes heraufbeschworen wird. Und in der Tat ist die bloße Existenz der Deepfake-Technologie ein Problem, allerdings anders, als es manche aufgeregte Debatte vermuten lässt.

2019 schaut der gabunische Staatpräsident bei seiner Neujahransprache starr in die Kamera. Er blinzelt selten, die Gesichtszüge wirken so, als wären sie mit Unmengen an Botox einbetoniert. Kein Wunder, denn Ali Bongo hat einen Schlaganfall gehabt und war deswegen längere Zeit von der Bildfläche verschwunden. Doch eine Gruppe von Militärs deutet Bongos irritierenden Gesichtsausdruck anders und glaubt, dass ein Deepfake dahinter steckt, Ali Bongo sei in Wirklichkeit schwer krank oder längst tot. Und so putschen die Soldaten und besetzten den Rundfunk.

Deepfakes untergraben das Vertrauen in reale Bilder

Der Putsch bricht wenig später in sich zusammen. Doch diese bizarre Episode zeigt etwas, worauf auch Giffeys Deepfake-Ausrede verweist: Das Problem mit Deepfakes sind nicht die Deepfakes selbst, sondern dass reale Bilder für Deepfakes gehalten werden und dass so das Vertrauen in reale Bilder untergraben wird.

Dilettantische Manipulationen werden für Deepfakes gehalten

Die Beispiele häufen sich: Letztes Jahr hieß es, niederländische Politiker seien in einer Videokonferenz auf einen Deepfake hereingefallen, der einen Vertrauten des russischen Oppositionellen Alexej Nawalny gezeigt haben soll. Dann stellte sich heraus: Die Politiker waren auf keinen Deepfake hereingefallen, sondern auf zwei YouTuber und ein bisschen Schminke. Es handelte sich übrigens um dieselben YouTuber, die nun Franziska Giffey hinters Licht geführt haben. Mittlerweile hat YouTube die beiden Kreml-nahen YouTuber von seiner Plattform verbannt, aber auf dem russischen YouTube-Pendant RuTube sind die Videos des Komiker-Duos "Vovan und Lexus" noch verfügbar und hier wird auch deutlich, wie dilettantisch teilweise die Manipulationen sind, die dann für Deepfakes gehalten werden.

Ebenfalls für Furore sorgte die Geschichte einer US-amerikanischen Mutter, die mit Hilfe der Deepfake-Technologie Videos von Cheerleader-Konkurrentinnen ihrer Tochter erstellt haben soll, die diese unter anderem beim Rauchen zeigen. Auch hier stellten sich die Deepfakes als simple Manipulationen heraus, ohne Einfluss von KI.

Die Deepfake-Panik ist bislang ein größeres Problem als die Deepfakes selbst

Es mag sein, dass Deepfakes irgendwann so perfekt sind, dass von ihnen eine Gefahr für die Demokratie ausgeht. Viele Deepfake-Manipulationen sind verblüffend und für den Laien kaum noch als solche zu erkennen. In der Tat verbreiteten Unbekannte zu Beginn des Ukraine-Krieges Deepfakes des ukrainischen Präsidenten Selenskyj und von Russlands Präsident Putin.

Allerdings können Videos auch mit herkömmlichen Methoden manipuliert werden. Die Manipulationen lassen sich zudem in der Regel gut detektieren, etwa mit Methoden die ihrerseits selbst auf künstliche Intelligenz setzen. Stand heute spricht deswegen viel dafür, dass die Deepfake-Panik einen größeren Schaden anrichten könnte als die Deepfakes selbst.

"Hier ist Bayern": Der BR24 Newsletter informiert Sie immer montags bis freitags zum Feierabend über das Wichtigste vom Tag auf einen Blick – kompakt und direkt in Ihrem privaten Postfach. Hier geht’s zur Anmeldung!