Eine Demo von Neonazis und mittendrin Miro Weber, der beim Bayerischen Rundfunk in der Abteilung "Digitale Entwicklung und Social Media" arbeitet. Miro Weber ist allerdings nie bei einer solchen Demo mitgelaufen, auch wenn ein kurzes Video auf den ersten Blick das Gegenteil zu beweisen scheint.

Doch wenn man genauer hinsieht, fallen sie einem schon auf, die kleinen, irritierenden Merkwürdigkeiten. Die Blickrichtung des Nazi-Miro wirkt etwas unnatürlich, sein Gesicht scheint seltsam zu flackern. Der Grund: Bei dem Video handelt es sich um einen "Deep Fake", um ein Video also, das mit Hilfe von künstlicher Intelligenz manipuliert wurde.

Aufregerthema "Deep Fakes"

"Deep Fakes" sind eines der aktuell größeren Aufregerthemen, wenn es um künstliche Intelligenz geht. Manch einer befürchtet, dass man in Zukunft auch bewegten Bildern nicht mehr trauen könne, es drohe die "Photoshopisierung" der Welt. Und in der Tat ist es so, dass mit Hilfe von künstlicher Intelligenz auch Laien in Zukunft in der Lage sein könnten, Videos zu manipulieren.

Miro Weber hat als Kameramann und Motion Artist zwar einiges an Erfahrung, wenn es um Bildbearbeitung geht. Für sein Experiment hat er jedoch versucht, sein Wissen auf diesem Gebiet zu ignorieren und möglichst naiv an die Sache heranzugehen.

Zufriedenstellende Ergebnisse nur mit viel "Gefrickel"

Sein Fazit: Man muss schon einiges an Zeit und Aufwand investieren, um zu einem Ergebnis zu kommen, das dann aber immer noch nicht perfekt ist. Wenn er alleine die KI die Arbeit machen ließ, entstanden oft Fehler. Dann sprang das Bild oder flackerte, manchmal lag ein Schatten auf dem Gesicht.

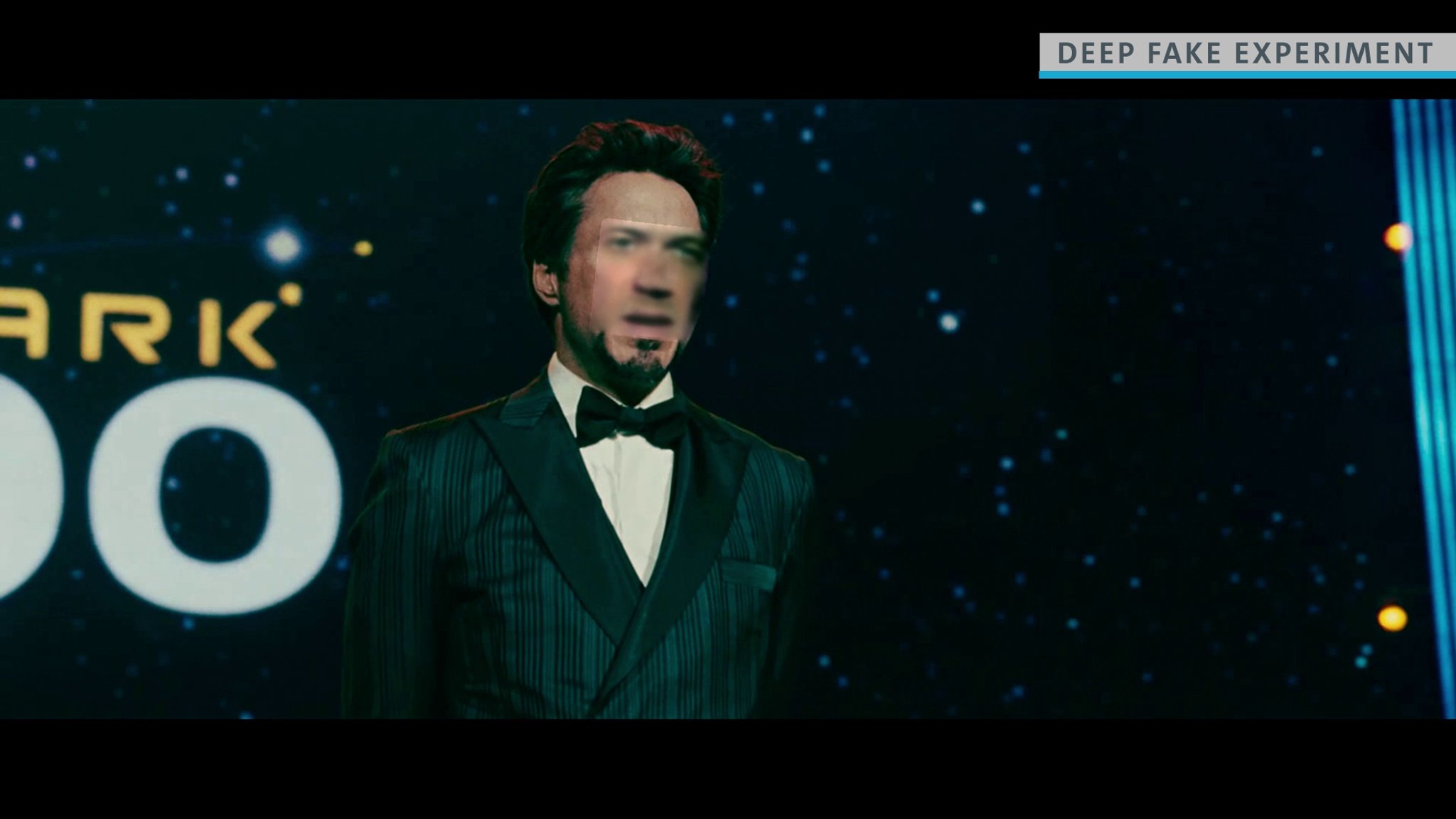

Klar ist: Ein "Deep Fake" zu erstellen ist leicht, aber einen guten "Deep Fake" zu erstellen ist schwer. Das sieht man auch an folgendem Beispiel. Hier wurde das Gesicht des BR-Netzredakteurs Christian Schiffer per Deep Fake-Technologie auf das von Tony Stark aus Iron Man montiert. Insgesamt lief der Rechner etwa zwei Stunden. Die Manipulation ist deutlich zu erkennen.

BR-Redakteur Christian Schiffer als "Opfer" eines Deep Fakes.

Der "Deep Fake" von Miro Weber wirkt da schon sehr viel professioneller. Im gelang es, die meisten Probleme mit Hilfe der Deep Fake-Software selbst lösen, allerdings nur mit viel "Gefrickel" und "Try and Error". Nur, wer viel Zeit und die Bereitschaft mitbringt, sich einzuarbeiten, kann also überzeugende Ergebnisse erzielen. Anleitungen, wie man einen Deep Fake erstellt und die notwendige Software sind im Netz offen zugänglich, es gibt auch YouTube-Tutorials.

Wie man "Deep Fakes" erkennt

Amateurhafte "Deep Fakes" sind leicht zu erkennen. Indizien können beispielsweise sein:

- Die Übergänge vom Fake zum realen Bild sind oft nicht sauber.

- Licht und Farben stimmen oft nicht überein.

- Blick wirkt leer und die Augen haben keinen Lidschlag.

Mit bloßem Auge ist oft auch zu erkennen, dass die Gesichter, die die Seite www.thispersondoesnotexist.com generiert, nicht echt sein können. Ohrringe und Ketten, werden merkwürdig dargestellt und da die KI auf Gesichter trainiert ist, ist der Hintergrund oft schlierig und unscharf.

Eine unscheinbare Frau, die es nicht gibt

Am Hintergrund ist deutlich zu erkennen, dass das Bild manipuliert ist

Das Problem: Bei gut gemachten "Deep Fakes" ist die Imitation so perfekt, dass sie das bloße Auge nicht mehr entlarven kann. Zudem gibt es auch reale Bilder und Videos, auf die manche dieser Kennzeichen zutreffen können.

Ali Bongo, der Präsident von Gabun, beispielsweise schaute Ende 2018 bei seiner Neujahrsansprache merkwürdig starr in die Kamera. Prompt kamen Gerüchte auf, bei dem Video könne es sich um einen "Deep Fake" handeln, was sogar in einem Militärputsch in dem zentralafrikanischen Land mündete. Vermutlich war der etwas irritierende Blick des gabunischen Staatsoberhauptes aber eher den Folgen eines Schlaganfalls geschuldet.

TU München führend bei Deep Fake-Erkennung

Zuverlässiger können "Deep Fakes" mit Hilfe von künstlicher Intelligenz erkannt werden, die TU München forscht auf diesem Gebiet führend. Die gute Nachricht ist: "Deep Fakes" zu erkennen ist einfacher, als sie zu erstellen, sagt Matthias Nießner der zu Deep Fakes forscht. Und: je besser die Algorithmen werden, um solche Fake-Videos zu erstellen, umso besser werden auch die Algorithmen, die wiederum solche Fake-Videos erkennen.

Miro Weber meint: Am Ende ist es ohnehin egal, ob ein Bild, ein Text oder ein Video gefälscht wird. Wenn das Timing stimmt und die Fälschung auf fruchtbaren Boden fällt, muss die Fälschung noch nicht einmal besonders gut gemacht sein, um ihre Wirkung zu entfalten.

Das allerdings war schon immer so und auch deswegen klären spezialisierte Fakten-Checker über Fälschungen und Fakes auf, egal, ob sie mit herkömmlichen Methoden erstellt wurden oder mit Hilfe von künstlicher Intelligenz.

Mehr über Deep Fakes und wie man sie erkennt, erfahren Sie in der aktuellen Ausgabe des "Umbruch"-Podcasts. "Umbruch" den Podcast des B5-Computermagazins können Sie hier abonnieren. Oder Sie suchen im Podcatcher ihrer Wahl nach "Umbruch".